Aumentare il Crawl Budget

Un crawl budget ottimizzato migliora la SEO

Autore: Andrea Pacchiarotti

Ultimo aggiornamento: 05 Maggio 2023

Categoria: Web Marketing SEO Crawl budget

Il crawl budget è un valore che Google assegna a un sito. Più è alto meglio è.

Gary Illyes ha pubblicato sulle pagine ufficiali di Google un articolo in lingua inglese che riguarda il Crawl Budget di Google e, tra le altre cose, ha dichiarato che tale parametro è meno importante per chi amministra un sito web di piccole dimensioni perché Googlebot gestisce in maniera efficace le risorse da assegnare e non ha problemi a fare crawling per la maggior parte dei siti. Il crawl budget è dunque un argomento che dovrebbe interessare per lo più grandi siti web, quelli con decine di migliaia di URL. In tal caso è d'aiuto per il crawling ridurre il numero di risorse embedded necessarie per effettuare il render di una pagina. Allora, vuoi sapere i metodi per aumentare il crawl budget e migliorare la SEO?

Sommario Crawl budget

- Googlebot

- Crawl budget

- Pagine sottoposte a scansione giornalmente

- Kilobyte scaricati giornalmente

- Tempo trascorso per il download di una pagina

- Migliorare il crawl budget

- Conclusioni

La nozione di Crawl Budget è scomponibile in:

- Crawl Rate Limit (Limite di Scansione): è un limite che aumenta o diminuisce a seconda che un sito risponda più o meno rapidamente alle visite del bot; se il sito rallenta o si hanno errori lato server, il crawl limit decresce e il bot farà meno scansioni, in caso contrario cresce. È possibile impostare a mano tale limite dalle Impostazioni di Search Console (cliccare sul sito in questione, poi sull’icona dell’ingranaggio e su Impostazioni sito; nella sezione Frequenza di scansione variare il limite di velocità), ma settando limiti più alti non è garantita più considerazione da parte di Googlebot.

- Crawl Demand (Esigenza di Scansione): è quanto il bot considera superato il contenuto di un URL; in casi particolari inerenti un sito intero (migrazioni, cambi di veste grafica), il Crawl Demand aumenta.

Googlebot

Google usa dei robot software (bot) per scansionare i siti web in Rete, essi leggono il contenuto di una pagina web e saltano al contenuto successivo servendosi dei collegamenti in essa contenuti.

Il Crawl Budget può essere descritto come la quantità di URL che il bot di Google è in grado e desidera scansionare e anche se non è un fattore SEO diretto, incide sulla visibilità di un sito in SERP. Se Googlebot scansiona spesso un sito significa che lo considera buono e che non riscontra problemi di scansione.

- inserito un nuovo sito in console (da Aggiungi Proprietà)

- sottoposto un file sitemap.xml (da Selezione proprietà Scansione Sitemap)

- richiesto il recupero di un certo URL (da Selezione proprietà Scansione Visualizza come Google)

Se non diversamente specificato nel file robots.txt e se non sono presenti errori di scansione (visualizzabili dalla Google Search Console andando su Scansione Errori di scansione), lo spider scansionerà l’intero sito, ma se nelle singole pagine incontrerà dei metatag robots potrebbe:

- non inserire il contenuto nell’indice (attributo noindex)

- non seguire i link della pagina (attributo nofollow)

Per trovare il numero di pagine del sito che Google dovrebbe indicizzare si possono scansionare le pagine con Screaming Frog o Visual SEO e conteggiare gli status code 200. Le pagine noindex e le 3xx, 4xx e 5xx possono essere ignorate dato che non verrebbero indicizzate.

Per trovare il numero di pagine indicizzate da Google (oltre l’operatore site:www.nomesito.it, non proprio preciso) si usa la voce Indice Google Stato dell’indicizzazione di Google Search Console.

Per sapere quanti URL vengono inviati a Google tramite sitemap.xml si usa la già citata voce Scansione Sitemap.

Crawl budget

Googlebot per scansionare un sito investe tempo ed energie e ciò si traduce in un costo monetario, bisogna quindi fare in modo che il crawl budget assegnato al proprio sito web richieda poche risorse al motore di ricerca. I crawler dei search engine consumano infatti risorse tangibili come ad esempio corrente e server. Per tale motivo un sito nuovo ha normalmente un basso crawl budget, cioè un numero relativamente ristretto di pagine scansionabili.

Se il crawler investe tempo su file insignificanti consumerà il numero di pagine da scansionare, con il rischio di tralasciare quelle importanti da posizionare; ciò significa che se la struttura di un sito consuma crawl budget su contenuti non fondamentali è una cosa negativa.

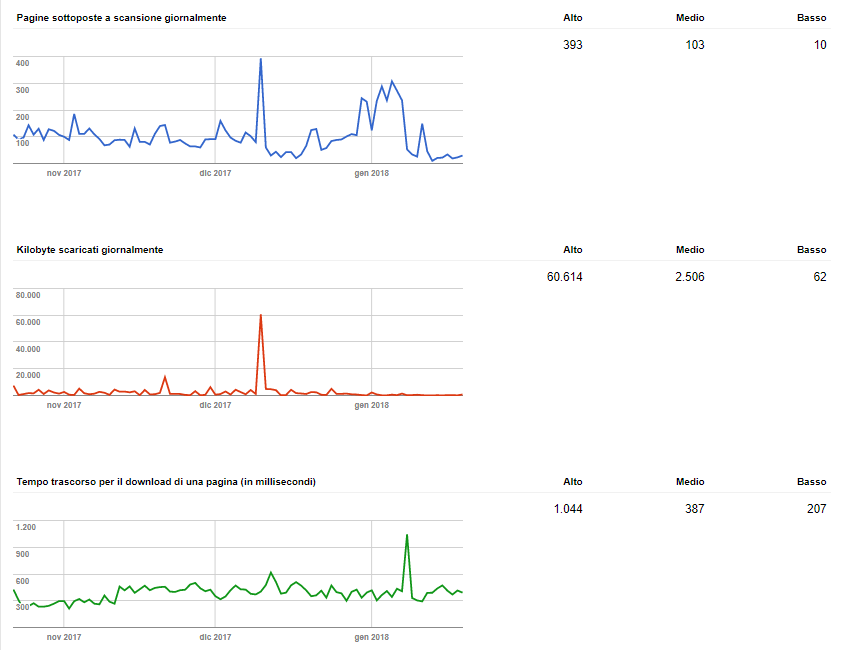

È possibile capire le statistiche di scansione dalla Search Console di Google, infatti selezionando la propria proprietà e andando su Scansione Statistiche di scansione si troveranno 3 grafici per ognuno dei quali si avrà a fianco il valore più alto, medio e basso degli ultimi 90 giorni e per i quali sarà possibile analizzare:

- Pagine sottoposte a scansione giornalmente:

il grafico è blu e indica con che frequenza le pagine sono scansionate dal motore; se ha un trend in salita la frequenza è in crescita perché ritenute buone risorse (i picchi, detti deep crawl, possono dipendere da modifiche massive al sito, generazione di pagine dinamiche, sito osservato da Google, ecc.), da ciò discendono i seguenti valori:

- Cattivo: le pagine scansionate giornalmente sono inferiori al totale delle pagine del sito (Google ha poco interesse a visitare le pagine)

- Buono: le pagine scansionate giornalmente sono pari al totale delle pagine del sito

- Ottimo: le pagine scansionate giornalmente sono maggiori del totale delle pagine del sito (Google è avido dei contenuti del sito e li scansiona spesso alla ricerca di aggiornamenti)

- Kilobyte scaricati giornalmente (da Googlebot): il grafico è rosso e dovrebbe tendere al ribasso perché significherebbe che per Google è facile ottenere i file. Il valore di ogni pagina scaricata è dato dalla divisione tra il valore di Kilobyte per il numero di pagine scansionate giornalmente

- Tempo trascorso per il download di una pagina (in millisecondi): il grafico è verde e dovrebbe tendere verso il basso perché significherebbe che il server è veloce a fornire i file. Sarebbe bene stare sempre sotto al secondo, l’ideale è scendere sotto il mezzo secondo

Il rapporto di scansione o Crawl ratio è dato da (media pagine scansionate al giorno pagine totali del sito web) moltiplicato 100 e indica quanto Google è interessato a fare la scansione di un sito. Sopra l’80% è già ottimo.

Il rapporto di indicizzazione o Index ratio è dato da (pagine indicizzate pagine totali del sito web) moltiplicato 100 e indica lo stato di indicizzazione cioè le pagine del sito indicizzate da Google. Sopra l’80% è già buono, sopra il 100% può significare varie cose: indicizzazione di file presenti nel server ma non linkati dal sito, canonical errati, ecc.

Il rapporto di indicizzazione della sitemap.xml o Sitemap ratio è dato da (pagine inserite in sitemap.xml pagine totali del sito web) moltiplicato 100. Sotto il 100% significa una sitemap incompleta, sopra vuol dire che la scansione è errata o che la sitemap include URL che non dovrebbe avere (ad esempio file con attributo noindex).

Migliorare il crawl budget

- ridurre il numero di risorse embedded necessarie per effettuare il render di una pagina

- aumentare il trust del sito accrescendo il numero di backlink di qualità. Il consiglio per acquisire link in entrata è lavorare sulla qualità dei contenuti affinché si abbiano buone ragioni per linkarli

- aumentare la frequenza di aggiornamento del sito in termini di nuovi contenuti di qualità pubblicati spesso. Schematizzando l’ipotetica scansione di un bot ci si rende conto quanto siano importanti gli aggiornamenti frequenti delle pagine:

supponendo che dopo la prima scansione di Googlebot ve ne sia un’altra dopo 24 ore, lo spider si chiederà se è stato effettuato un aggiornamento del contenuto, se la risposta è affermativa farà un’ulteriore scansione dopo 12 ore, altrimenti dopo 48; successivamente si chiederà di nuovo se è stato fatto un aggiornamento dei contenuti e in caso positivo ridurrà ulteriormente l’intervallo temporale di scansione portandolo da 12 a 6 ore, altrimenti l’incrementerà portandolo da 48 a 96 e così via - aumentare la velocità del sito web ovvero la risposta del server nel servire a Googlebot la pagina richiesta (ecco perché è meglio acquistare un server veloce): se il sito risponde rapidamente aumenta la frequenza della scansione, altrimenti diminuirà. Un buon hosting deve avere SSD, http/2 e un buon up-time (Siteground è ottimo specialmente se si utilizza un CMS come WordPress)

- tenere pulito il server: cancellare tutti i file che non sono linkati realmente dal sito

- far risaltare i contenuti importanti del sito impostando l’attributo noindex ai link poco importanti per il ranking. Se l’importantissimo menù di un sito e-commerce ha una voce Prodotti e altre 9 linkate ad esempio a Chi Siamo, Contatti, ecc. non possiamo biasimare Google se non privilegia la scansione dei prodotti; di conseguenza usare il file robots.txt per togliere importanza ai contenuti irrilevanti onde evitare che Googlebot scansioni pagine che hanno all’interno l’attributo noindex, ciò permetterà al bot di concentrarsi sulle pagine migliori del sito evitando la scansione di quelle inutili.

Dunque deve essere il file robots.txt a indicare la strada migliore al bot, in quanto qui è possibile decidere le pagine che Googlebot dovrà ignorare impostandole con noindex.

Prima di usare noindex eliminare tutte le pagine inutili, perché fuori argomento o accorpare quelle con poco contenuto o quasi identiche e quelle che portano poco traffico.

Allo stesso modo l’attributo nofollow sui link in uscita, permette di stabilire gerarchie tra le pagine, segnalando a Google quelle più importanti. Nell’esempio del menù a 10 voci di prima attribuendo il nofollow ai collegamenti che linkano a Chi Siamo e Contatti, si segnala a Google che le altre pagine sono più importanti - gestire le sitemap: in essa vanno inseriti solo i contenuti che devono essere indicizzati, evitando le altre pagine tra cui quelle con attributo noindex

- parametri URL: Google Search Console può indicare al bot come gestire i parametri URL. Un problema degli e-commerce, è la gestione di varianti di pagina tramite parametri; se ad esempio non si gestisce l’ordinamento crescente e decrescente dei prodotti per prezzo, data, nome, ecc., oltre a incappare in un problema di contenuto duplicato, si stanno facendo scansionare a Google più pagine invece di una. Se le categorie di prodotti sono 10, se ne sta facendo scansionare un suo multiplo

- variazione delle impostazioni: è possibile ridurre o aumentare la scansione di un sito agendo sulla Google Search Console; selezionando una proprietà, si clicchi l’icona dell’ingranaggio in alto a destra e si selezioni Impostazioni sito, nella pagina che appare si selezioni limita la velocità massima di scansione di Google abbassando o aumentando la frequenza. Un aumento di tale valore non dà garanzia di un aumento della frequenza (qualcuno potrebbe anche pensare di usare la direttiva crawl-delay nel file robots.txt, meglio di no, è inutile)

- popolarità: gli URL con CTR maggiore quando cliccati dalla SERP di Google verranno scansionati più spesso in cerca di eventuali modifiche al contenuto

- ottenere più condivisioni sui Social

- modificare gli URL di un sito, in tal modo Googlebot reindicizzerà le diverse pagine (ad esempio variazione dell’attributo noindex a index) con conseguente aumento della frequenza di scansione

- Fare il test di ottimizzazione mobile e migliorare i punti deboli

- il bot non deve perdere tempo in percorsi inutili, per questo bisogna avere URL di alto valore; i fattori che identificano un URL come cattivo sono:

- contenuti duplicati

- pagine con errori non gravi, hackerate o spammose

- contenuti di bassa qualità

- pagine che richiedono un clic supplementare per mostrare il contenuto

- Errori 404 (broken link)

- Informazioni di servizio

Conclusioni

La scansione fatta da Googlebot è uno degli argomenti più sottovalutati della Search Console anche se dà preziose informazioni sulle attività che Google attua su un sito web e consente di capire che reputazione ha il sito per Google.

Specialmente nei siti con più di 10.000 URL è necessario porre attenzione al crawl budget adottando tutte le migliorie elencate in modo tale da far scansionare il proprio sito ogni giorno, o più volte al giorno, segnale certo che le pagine piacciono a Google. Fare in modo che non ci siano dispersioni del budget (che è limitato) darà certamente una mano determinante sotto l’aspetto SEO.

Se i metodi per aumentare il crawl budget e migliorare la SEO ti è piaciuto, condividi l'articolo!

Per saperne di più sul Web Marketing potrebbero interessarti questi libri: